生成型の人工知能(AI)モデルは高度な機能を備えるが、虚偽の情報を生成してハルシネーション(幻覚)を起こしたり、悪意ある人物に悪用される恐れのある抜け穴があったりする事例が、数多く確認されている。Microsoftはこの問題の緩和を支援するため、生成AIシステムのリスクを特定するのに役立つツールを発表した。

Microsoftは米国時間2月22日、「Python Risk Identification Toolkit for generative AI(PyRIT)」をリリースした。これは、MicrosoftのAI Red Teamが、「Copilot」を含む同社の生成AIシステム内のリスクを確認するために使用しているツールだ。

Microsoftはこの1年間で、複数の高価値の生成AIシステムに対するレッドチーミングを行い、その経験を通して、それらのシステムのレッドチーミングが従来のAIやソフトウェアに対するものとは大きく異なることを学んだと、発表の中で述べた。

異なる点の1つは、通常のセキュリティリスクに加えて、有害なコンテンツや偽情報の生成など、責任あるAIのリスクを考慮しなければならないことだという。

また、生成AIモデルはアーキテクチャーがそれぞれ大きく異なり、同じ入力から生成できる結果にばらつきがあるため、すべてのモデルに適合する、合理化された1つのプロセスを見つけるのが難しい。

その結果、それらのさまざまなリスクの1つ1つを手動で調べる作業が、退屈で時間のかかる、低速なプロセスになってしまう。Microsoftは、自動化がレッドチームに役立つとして、より注意が必要なリスクの高い部分を自動で特定し、定型的なタスクを自動化することができるとしている。そこで登場するのが、PyRITというわけだ。

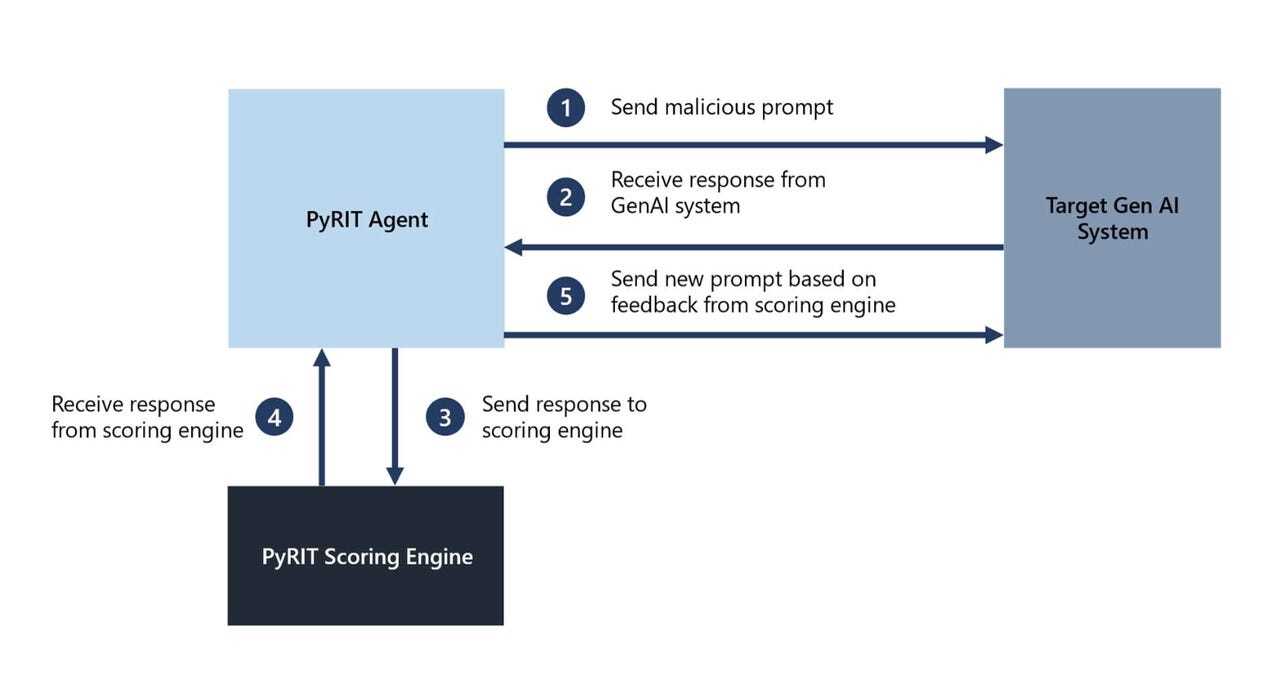

PyRITは、悪意のあるプロンプトを生成AIシステムに送信し、返ってきた応答を評価する。その評価に基づいてまた新たなプロンプトを送信するという。

MicrosoftはPyRITの最大のメリットとして、作業効率が向上し、作業にかかる時間が大幅に短縮されることを挙げている。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。

CNET Japanの記事を毎朝メールでまとめ読み(無料)

ビジネスの推進には必須!

ビジネスの推進には必須!

ZDNET×マイクロソフトが贈る特別企画

今、必要な戦略的セキュリティとガバナンス

誰でも、かんたん3D空間作成

誰でも、かんたん3D空間作成

企業や自治体、教育機関で再び注目を集める

身近なメタバース活用を実現する

脱炭素のために”家”ができること

脱炭素のために”家”ができること

パナソニックのV2H蓄電システムで創る

エコなのに快適な未来の住宅環境

データ統合のススメ

データ統合のススメ

OMO戦略や小売DXの実現へ

顧客満足度を高めるデータ活用5つの打ち手